はじめに

近年、ディープラーニング(深層学習)は、画像認識や自然言語処理など、さまざまな分野で飛躍的な発展を遂げています。

しかし、ディープラーニングのモデルは、膨大なデータと計算リソースを必要とするため、効率的な学習方法が求められています。

そこで登場するのが「ミニバッチ学習」です。ミニバッチ学習は、ディープラーニングモデルが膨大なデータセットを効率的に処理できるようにするための手法です。

本記事では、ミニバッチ学習の基本的な概念や、その重要性、そしてパラメータ更新の仕組みについて詳しく解説していきます。

ミニバッチ学習は、深層学習を理解するうえで非常に重要な知識となりますが、これらについて理解が難しい場合は、経験豊富な方とマンツーマンで学習していくのもオススメです。

ミニバッチ学習とは

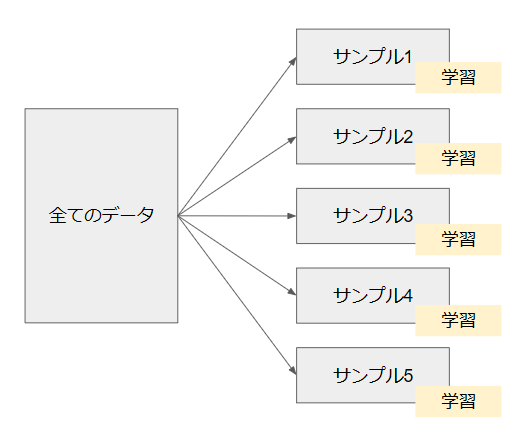

ディープラーニングでは、全てのデータを一度に処理するのは計算リソースの観点から非常に負担が大きいです。

そのため、データを小さなグループ(バッチ)に分けて、それぞれでモデルを学習させる「ミニバッチ学習」という手法が広く用いられています。

ミニバッチ学習の目的

ミニバッチ学習の目的は、大量のデータセットを効率的かつ効果的に処理し、モデルのパラメータを更新することです。

一般的に、データセット全体を一度に処理することはメモリ使用量が大きくなり、計算時間がかかってしまいます。このため、ミニバッチ学習では、データセットを小さなサンプル群(ミニバッチ)に分割し、それぞれのミニバッチでパラメータを更新します。

ミニバッチ学習の目的は、以下のような点にあります。

- 計算コストの削減

ミニバッチ学習では、データセットを小さなサンプル群に分割することで、処理に必要なリソースを削減できます。 - モデルの汎化性能の向上

ミニバッチ学習は、大規模なデータセットからランダムにサンプルを選択するため、モデルが過剰適合(オーバーフィッティング)することを防ぐことができます。

総じて、ミニバッチ学習は、大規模なデータセットを処理するための効果的な方法で、モデルの学習を効率的かつ効果的に行うことができます。

ミニバッチ学習の重要性

ミニバッチ学習は、深層学習において非常に重要な役割を果たしています。

データセットが大量の場合、一度に全てのデータを扱うことはほとんど不可能であるため、ミニバッチ学習は実用的な学習手法として広く使われています。

また、ミニバッチ学習では、各バッチごとにパラメータの更新を行うため、SGDと呼ばれる最適化手法等と組み合わせて使うことができます。

ミニバッチのパラメータ バッチサイズ

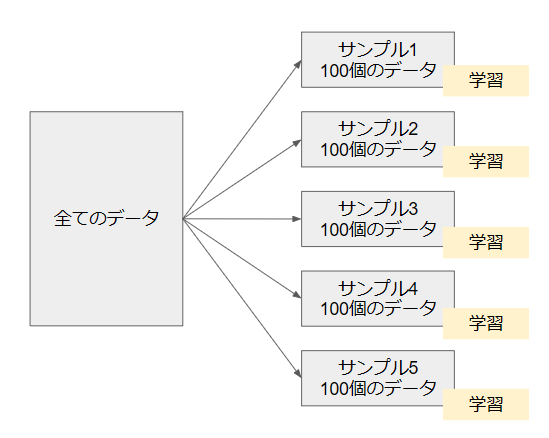

ミニバッチ学習のパラメータとしてバッチサイズがあります。各サンプルにどれだけデータを持つかというパラメータになります。一般的には、バッチサイズは2の累乗です。

ディープラーニングを学習する際、下記のようにバッチサイズを決定して進める必要がありますが、バッチサイズ=100と指定すると下記のようにデータを取り、学習します。

バッチサイズが大きい場合は、メモリ使用量が増加し、処理が遅くなる可能性があります。一方、バッチサイズが小さい場合は、パラメータの更新頻度が増え、局所解に陥る可能性が減りますが、全体的な学習時間が長くなることがあります。

まとめ

ミニバッチ学習は、深層学習において非常に重要な学習手法の1つです。データセットを小さなバッチに分割し、各バッチごとに学習を行うことで、メモリや計算資源を節約しながら、過学習を防ぐことができます。

また、SGDと組み合わせて使うことで、最適な解に収束するように学習を進めることができます。

ディープラーニングにおすすめの方法

書籍:ゼロから作るDeep Learning

こちらの書籍はディープラーニングの基本が網羅的にまとめられており、基本を身に着けるのにおススメです。ディープラーニングは応用先も多いため、基礎をこちらの書籍で学ぶことをおススメします。

スクール:現役データサイエンティストに教えてもらう

ディープラーニングを構成する技術は様々な場面で活用されるため、網羅的に学習することがオススメです。

ただ、どのようにやるのが正しいのかを判断するには適切なメンターなどがいた方が安心です。スクールなどに入り、アドバイスしてもらいながら進めるのも良いでしょう。

コメント